1. معرفی

سیل تهدید قابل توجهی برای اشغال انسان از چشم انداز است و منجر به بیشترین خسارت مالی ناشی از بلایای طبیعی می شود. این امر سکونتگاههای انسانی را مختل میکند، به زیرساختها آسیب میزند و خسارات بیشماری در اقتصاد محلی و املاک مسکونی ایجاد میکند. سیل یک نوع رایج بلایای طبیعی در ایالات متحده است [ 1 ]. در حالی که الگوی بارندگی شدید ممکن است از گرم شدن کره زمین در حال تغییر باشد، سیل در ایالات متحده بیشتر می شود [ 2 ]. در سالهای اخیر، ایالات متحده از چندین سیل شدید مانند سیل لوئیزیانا در سال 2016، سیل هیوستون در سال 2017 و طوفان فلورانس در سال 2018 آسیب دیده است. خسارات ناشی از سیل در ایالات متحده در سال 2017 به 60 میلیارد دلار رسید [ 3 ] .].

آگاهی از موقعیت و نقشه برداری سیل مستلزم اطلاع اولیه از محل وقوع سیل و شدت آن است (که معمولاً در جامعه بلایای طبیعی به عنوان “چقدر بزرگ و چقدر بد” نامیده می شود). نقشه های سیلاب به منظور تعریف وسعت و شدت سیل، پیش بینی سیل و نقشه برداری دشت سیلابی عمل می کند [ 4 ، 5 ]. سازمان زمین شناسی ایالات متحده (USGS) معمولاً یک تیم را پس از یک رویداد سیل بزرگ برای جمع آوری واترمارک های بالا در میدان اعزام می کند. این نقشهها اغلب ماهها پس از وقوع سیل بهطور رسمی منتشر میشوند [ 6 ]، و در حالی که برای کاهش و مدلسازی مفید هستند، هیچ به موقعی برای یک رویداد سیل فعلی وجود ندارد.

اطلاعات جغرافیایی داوطلبانه (VGI) یک راه حل بالقوه برای نقشه برداری سریع سیل است [ 7 ]. کاربران رسانه های اجتماعی (به عنوان مثال، توییتر، فیس بوک) که به عنوان “حسگرهای انسانی” در زمینه VGI شناخته می شوند، اطلاعاتی را در مورد محیط فیزیکی و اجتماعی خود جمع آوری و پخش می کنند [ 8 ، 9 ، 10 ]. مطالعات اخیر نشان داد که پستهای رسانههای اجتماعی بلادرنگ، رایگان و دارای برچسب جغرافیایی میتوانند در آگاهی از وضعیت سیل و نقشهبرداری سریع مورد استفاده قرار گیرند [ 6 ، 11 ، 12 ، 13 ، 14 .]. بسیاری از این مطالعات، عکسهای آپلود شده در پستهای مربوط به سیل را به عنوان اطلاعات بصری در محل حیاتی برای افزایش آگاهی موقعیت سیل مشاهده کردهاند. به عنوان مثال، یک عکس ارسال شده توسط یکی از ساکنان که حیاط آب گرفته را نشان می دهد برای ارزیابی ارتفاع آب و شرایط کاری برای کنترل سیل در مجاورت مفید است.

با این حال، استخراج کارآمد و دقیق عکسهای مفید مرتبط با سیل از مقادیر انبوه دادههای شبکههای اجتماعی بدون ساختار، چالشهای قابلتوجهی ایجاد میکند. به عنوان مثال، در نوامبر 2018 تقریباً 5000 توییت در هر ثانیه پست شد [ 15 ]. این توییتها موضوعات مختلفی را پوشش میدهند و موضوعات مرتبط با سیل نسبتهای بسیار کمی را نشان میدهند. در میان آن مطالعات پیشگام، فیلتر دستی مبتنی بر کلیدواژه پست های مرتبط با سیل، روش غالب است [ 6 ، 11 ]] اما با محدودیت های آشکار. ابتدا، اگر هیچ کلمه کلیدی مرتبط با سیل در متن وجود نداشته باشد، ممکن است پست هایی که حاوی عکس های سیل هستند نادیده گرفته شوند. دوم، بررسی دستی پست های رسانه های اجتماعی گسترده ناکارآمد است و منجر به غیرعملی بودن تجزیه و تحلیل بلادرنگ می شود.

چالشهای اساسی برای شناسایی خودکار مرتبط و استخراج اطلاعات مرتبط با سیل از تصاویر پستشده در رسانههای اجتماعی وجود دارد. تصاویر آپلود شده ممکن است شامل اسکرین شات از متن، پوستر، تصاویر، کارتون، تبلیغات، عکس های اصلاح شده باشد. برای یک رویداد سیل، تصاویر روی موضوع تنها بخشهای کوچکی از کل مجموعه داده را نشان میدهند، و این به ویژه برای توییتهایی با اطلاعات جغرافیایی صادق است. به عنوان مثال، توییت های دارای برچسب جغرافیایی جهانی با “سیل” تنها 0.034٪ از توییت های دارای برچسب جغرافیایی از رابط برنامه کاربردی پخش جریانی توییتر (API) را نشان می دهد. عکسهای توییتشده از دستگاهها، زوایای و محیطهای مختلف گرفته شدهاند و اهداف مختلفی را دنبال میکنند. خودسری یک عکس پیوست شده، عدم قطعیت در نتایج تشخیص را تشدید می کند. بدین ترتیب، اجرای یک روش تشخیص عکس سیل کاملاً خودکار دشوار است و قبل از استفاده از عکسهای برچسبگذاری شده سیل، به مرحله تأیید نهایی دستی نیاز است. علاوه بر این، اطلاعات مکان برای آگاهی و واکنش موقعیتی بلایای طبیعی حیاتی است، به طوری که تأیید مکان آن عکسهای سیل مورد نیاز است. در حال حاضر، هیچ روش عملی برای انجام تأیید موقعیت مکانی به جز کار دستی وجود ندارد. بنابراین، یک رویکرد عملی، ساختن سیستمی است که بتواند به طور خودکار عکس های نامربوط را فیلتر کند و مقدار نسبتاً کمی از عکس های سیل را برای تأیید دستی ارائه دهد. اطلاعات مکان برای آگاهی و پاسخ به موقعیت فاجعه حیاتی است، به طوری که تأیید مکان آن عکس های سیل مورد نیاز است. در حال حاضر، هیچ روش عملی برای انجام تأیید موقعیت مکانی به جز کار دستی وجود ندارد. بنابراین، یک رویکرد عملی، ساختن سیستمی است که بتواند به طور خودکار عکس های نامربوط را فیلتر کند و مقدار نسبتاً کمی از عکس های سیل را برای تأیید دستی ارائه دهد. اطلاعات مکان برای آگاهی و پاسخ به موقعیت فاجعه حیاتی است، به طوری که تأیید مکان آن عکس های سیل مورد نیاز است. در حال حاضر، هیچ روش عملی برای انجام تأیید موقعیت مکانی به جز کار دستی وجود ندارد. بنابراین، یک رویکرد عملی، ساختن سیستمی است که بتواند به طور خودکار عکس های نامربوط را فیلتر کند و مقدار نسبتاً کمی از عکس های سیل را برای تأیید دستی ارائه دهد.

یادگیری عمیق یا رویکردهای شبکه عصبی مصنوعی چند لایه، از سال 2012 توسعه سریعی یافته است [ 16 ]. به طور گسترده ای برای شناسایی اشیاء، تشخیص گفتار یا تطبیق موارد استفاده می شود [ 16 ]. به عنوان یک روش فیلتر غیر دستی و کارآمد، یادگیری عمیق یک رویکرد امیدوارکننده برای استخراج پست های مرتبط با سیل از داده های رسانه های اجتماعی عظیم است [ 17 ]. به عنوان مثال، مطالعات اخیر [ 18 ، 19 ، 20] هم متن و هم تصویر یک پست را تجزیه و تحلیل کرد تا مشخص کند آیا پست مربوط به سیل است یا خیر. مهمتر از آن، روش یادگیری عمیق میتواند دادههای عظیم رسانههای اجتماعی را در زمان واقعی پردازش کند و اطلاعات به موقع را برای اولین واکنش تیم مدیریت بلایای محلی ارائه دهد.

با توجه به این چالش ها و پیشرفت یادگیری عمیق، این مقاله یک گردش کار کامل را برای استخراج و تأیید عکس های سیل برای رسانه های اجتماعی بررسی می کند. ابتدا نمونه های آموزشی با بازرسی ده ها هزار عکس سیل جمع آوری شد. سپس معیارهای دقیق برای شناسایی عکس سیلاب برای سیستم تعیین شد. در نهایت، یک معماری متمرکز مبتنی بر پایگاه داده و دارای پلاگین بر اساس تکنیک یادگیری عمیق طراحی و پیادهسازی شد که سیستم را قادر میسازد عکسهای سیل را در زمان واقعی نمایش دهد. معماری پلاگین سیستم را قادر میسازد تا با افزودن پلاگینهای جدید، سایر کارهای تجزیه و تحلیل تصویر در زمان واقعی مانند غربالگری عکسهای آتشسوزی را انجام دهد.

2. کارهای مرتبط

2.1. طبقه بندی تصاویر بر اساس یادگیری عمیق

هدف از طبقهبندی تصویر (که به آن دستهبندی یا برچسبگذاری تصویر نیز گفته میشود) اختصاص دادن یک تصویر به یک کلاس با توجه به محتوای آن است. به عنوان مثال، با توجه به عکس یک گربه، الگوریتم احتمالات مجموعه ای از برچسب های نامزد، مانند گربه، سگ یا ببر را برمی گرداند. یک الگوریتم واجد شرایط باید احتمال بسیار بالاتری را به برچسب گربه نسبت به سایر برچسب ها اختصاص دهد. قبل از پارادایم یادگیری عمیق، الگوریتم کیسه کلمات (BoW) محبوب ترین و موفق ترین رویکرد برای چنین برچسب گذاری تصاویر بود [ 21 ]. ویژگیهای تصویر توسط توصیفگرها استخراج میشوند، مانند SIFT (تبدیل ویژگی ثابت مقیاس [ 22 ]) و SURF (ویژگیهای قوی سریعتر [ 23 )])، که واژگان را تشکیل می دهند. روشهای BoW با ویژگیها مانند کلمات برخورد میکنند و سپس تصاویر را بر اساس ویژگیهایشان در واژگان خوشهبندی میکنند. یک روش BoW نمی تواند از بافت فضایی ویژگی ها هنگام استخراج اشیاء در تصاویر سوء استفاده کند. SVM (ماشین بردار پشتیبان) و مدل های سلسله مراتبی آن از دیگر روش های محبوب برای برچسب گذاری تصویر هستند.

رویکردهای شبکه عصبی عمیق در دهه گذشته پیشرفت چشمگیری داشته است. به عنوان مثال، در چالش ILSVRC 2012، رقبا باید با آموزش طبقه بندی کننده های خود با 1.2 میلیون تصویر، 150000 تصویر آزمایشی را در 1000 کلاس طبقه بندی می کردند. AlexNet با دقت قابل توجهی جلوتر از رتبه دوم که بر اساس روش های غیر شبکه عصبی بود (16٪ در مقابل 26.2٪ در میزان خطا) برنده شد. در سالهای اخیر، میزان خطا به دلیل استفاده از CNNهای پیچیدهتر، مانند VGG [ 24 ] و ResNet [ 25 ] کاهش یافته است.]. چارچوب های یادگیری عمیق منبع باز محبوب (به عنوان مثال، Tensorflow، Pytorch) این CNN های آموزش دیده را ارائه می دهند، و کاربر می تواند به راحتی آنها را برای طبقه بندی تصاویر یا آموزش CNN ها با مجموعه داده های آموزشی سفارشی استفاده کند. ILSVRC 2017 جدیدترین چالش طبقه بندی تصویر است که در آن میزان خطا برای طرح برنده به 2.251% کاهش یافته است، که بسیار بهتر از عملکرد انسانی حتی 5% [ 26 ]. بر اساس این نتایج، سازماندهنده چالش، سؤال طبقهبندی تصویر را حل شده در نظر گرفت و رقابت را پایان داد – بدون چالش در آینده.

CNN ها همچنین می توانند برای کارهای خاص طراحی شوند. Gebru [ 27 ] اتومبیلها را در نمای خیابان Google شناسایی و طبقهبندی کرد، و پیشبینی درآمد جامعه را با همبستگی بالا با دادههای مرجع زمینی به دست آورد (r = 0.82). CNN مبتنی بر AlexNet 50 میلیون تصویر از 200 شهر بزرگ آمریکا را شناسایی و خودروها را در 2600 دسته طبقه بندی کرد. نویسندگان از خودروهای شناسایی شده برای انجام یک مطالعه جامعه شناختی مرتبط با جمعیت شناسی محلی استفاده کردند. آشکارساز ماشین ریزدانه که توسط 347811 نمونه آموزش داده شده است، داده های اولیه را در این جستجو ارائه می دهد. گروه دیگری از نویسندگان [ 28] یک CNN را برای تشخیص بیماری های گیاهی آموزش داد. آنها از 4483 تصویر برای آموزش AlexNet برای طبقه بندی 13 بیماری برگ، از جمله سیب و هلو استفاده کردند. AlexNet آموزش دیده دقت متوسط 96.3٪ را به دست آورد. طبقهبندی تصویر بر اساس CNN در بسیاری از زمینههای کاربردی دیگر، مانند تجزیه و تحلیل تصویر پزشکی [ 29 ، 30 ، 31 ] و تشخیص حیوانات [ 32 ] نیز اعمال شد.

2.2. طبقه بندی عکس سیل

در حالی که تجزیه و تحلیل متن رسانه های اجتماعی به طور گسترده مورد مطالعه قرار گرفته است، اطلاعات بصری یا تصاویر ارسال شده مطابق بهترین دانش ما از ادبیات فعلی مورد بررسی قرار نگرفته است. عبارت “تصویر” مورد اشاره در این تحقیق به معنای انواع تصاویر ارسال شده در شبکه های اجتماعی از جمله عکس، اسکرین شات و سایر فایل های شطرنجی پیوست شده است. در این مطالعه، “عکس” تصویری است که از دوربین های صحنه های طبیعی (یعنی نه مصنوعی) به دست می آید. عکسها اطلاعات بصری در سایت را ثبت میکنند، در حالی که سایر انواع تصاویر ممکن است هیچ ارتباطی با محیط در سایت نداشته باشند. در این مطالعه، ما بر تجزیه و تحلیل تصویر رسانه های اجتماعی در هنگام وقوع سیل تمرکز کردیم. بهویژه، عکسهای ارسال شده که وضعیتهای جاری سیل را نشان میدهند، عکسهای سیل هستند. بازتوییت ها و اسکرین شات ها از رسانه های عمومی به سختی قابل بومی سازی هستند،

طبقه بندی عکس سیل به یک موضوع تحقیقاتی جدید در مدیریت بلایا تبدیل شده است. وظیفه ماهواره چندرسانه ای در MediaEval [ 33 ]، رقابتی برای تشخیص عکس فاجعه و طبقه بندی تصاویر ماهواره ای، با هدف ارتقاء دسترسی چند رسانه ای و الگوریتم های بازیابی است. در سالهای 2017 و 2018، این وظیفه بر روی رویداد سیل متمرکز بود. شرکت کنندگان متن و عکس های رسانه های اجتماعی را با هم ترکیب کردند تا مشخص کنند که آیا یک توییت مرتبط با سیل است یا خیر. روش های برتر در سال 2017 به دقت بالاتر از 95 درصد رسیدند [ 34 ]. داده های آموزشی از مجموعه داده های تصویری YFCC100M [ 35 ] به دست آمد اما معیار خاصی در مورد عکس های سیلابی نداشت. محققان از عبارت «سطوح بالای آب غیرمنتظره در مناطق صنعتی، مسکونی، تجاری و کشاورزی به عنوان تعریف عکس سیل. حاشیه نویسان انسانی عکس را در مقیاس 1 تا 5 با توجه به قدرت شواهد سیل رتبه بندی کردند. این مسابقه بر کاربرد و به کارگیری این الگوریتم ها تاکیدی نداشت.

روشهای مبتنی بر CNN برای شناسایی توییتهای سیلآمیز در ادبیات غالب هستند. Paper [ 20 ] از CNN 8 لایه ای برای طبقه بندی عکس های سیل از توییت ها استفاده کرد و سپس از کلمات متداول در پست های متنی در طول یک رویداد سیل استفاده کرد تا نتایج تشخیص را اصلاح کند. دقت نهایی در یک مجموعه تست متعادل 87.4٪ بود. یک CNN ترکیبی بصری-بنی در [ 19 ] اعمال شد، که در آن یک Inception V3 [ 36 ] CNN برای تصویر توییت شده و یک Word2Vec [ 37 ] استفاده شد.روش ] برای تبدیل متن توییت شده به آرایه ای که به CNN دیگری تغذیه می شود، استفاده شد. آن دو سیانان استخراجشده از توییت، بردار 1024 بعد از تصویر و متن را تولید کردند. سپس این دو بردار برای آموزش مدلهای یادگیری ماشین، مانند SVM، برای طبقهبندی توییتهای سیلآمیز به هم متصل شدند. دقت 96.5 درصد در یک مجموعه تست متعادل به دست آمد.

فنگ و سستر [ 18 ] از CNN و روشهای دیگر برای طبقهبندی توئیتهای مرتبط با سیلاب استفاده کردند. هم متن و هم عکس در توییت ها با هم ترکیب شده و به عنوان مرتبط یا نامربوط طبقه بندی شدند. نویسندگان از سه زیرمجموعه (هر کدام 7600 عکس) که از توییتر و اینستاگرام جمع آوری شده بودند برای آموزش مدل استفاده کردند. زیر مجموعه 1 حاوی تصاویری از رسانه های اجتماعی است. این تصاویر بی ربط بودند و توسط حاشیه نویسان انسانی انتخاب شدند. زیرمجموعه 2 سیل عکسهایی از رویدادهای شناخته شده در پاریس، لندن و برلین بود. زیرمجموعه 3 شامل عکسهایی از سطوح آب طبیعی (غیر سیلزده) مانند دریاچهها بود. دو طبقهبندیکننده تصویر به ترتیب برای تشخیص عکسهای سیل از زیرمجموعه 1 و زیر مجموعه 2 آموزش داده شدند. اگر هر دو طبقهبندیکننده آن را بهعنوان سیل در نظر بگیرند، عکسی بهعنوان مرتبط با سیل شناسایی شد. بالاترین امتیاز F1 [ 38] به عنوان 0.9288 گزارش شده است.

اگرچه این مطالعات بر روی تشخیص عکس سیل پخش شده در رسانه های اجتماعی انجام شده است، اما اهداف آنها برای کاربردهای بیشتر و استانداردهای جمع آوری داده ها مشخص نیست. مجموعه داده های شبیه سازی شده فاقد اطلاعات زمان واقعی و ویژه رویداد هستند. ما معتقدیم که عکسهای سیل کشفشده اطلاعاتی در مورد رویدادهای جاری سیل ارائه میکنند. همچنین، اکثر مطالعات آزمایشی به طور سیستماتیک گردش کار کلی، مانند اکتساب تصویر، کلیت سیستم و توسعه پذیری را در نظر نمی گیرند. علم و همکاران [ 39] یک سیستم پردازش تصویر آنلاین در رسانه های اجتماعی را برای ارزیابی شدت آسیب گزارش کرد، اما آنها فقط یک تابع طبقه بندی تصویر را ارائه کردند. علاوه بر این، یک سیستم تشخیص عکس سیل را می توان به عنوان یک سیستم تجزیه و تحلیل تصویر تعمیم داد تا با وظایف مختلف تجزیه و تحلیل تصاویر، مانند طبقه بندی تصویر و تشخیص اشیا، مقابله کند. در این مطالعه، ما یک تجزیه و تحلیل تصویر بلادرنگ برای رسانه های اجتماعی (RIASM) ایجاد کردیم تا این اهداف چندگانه را برآورده کنیم. ما همچنین عملکرد RIASM را هنگام اعمال آن در مجموعه دادههای بسیار نامتعادل از محیط تولید گزارش کردیم، که در ادبیات فوق گزارش نشده بود.

3. روش شناسی

3.1. معماری سیستم

این تحقیق برای پیادهسازی سیستمی برای غربالگری عکسهای سیل برچسبگذاری شده از پستهای رسانههای اجتماعی عظیم برای آگاهی سریع از وضعیت سیل انجام شد. اولین کار جمعآوری نمونههای عکس سیل برای ایجاد یک مجموعه داده آموزشی برای طبقهبندی عکسهای سیلآلود/غیر سیل بود. بر اساس مجموعه کوچکی از عکسهای سیل جمعآوریشده بهصورت دستی، یک روش تکراری برای آموزش یک طبقهبندیکننده CNN برای جمعآوری عکسهای سیل بیشتر از تصاویر رسانههای اجتماعی استفاده شد. به منظور نمایش عکسهای رسانههای اجتماعی در زمان واقعی، چندین ماژول مستقل برای وظایف فرعی زیر توسعه داده شد: دانلود توییت، دانلود تصویر، تجزیه و تحلیل تصویر، و تایید نتیجه. یک پایگاه داده MySQL برای ذخیره و تبادل داده ها از این ماژول ها استفاده شد.شکل 1 معماری سیستم پیشنهادی را نشان می دهد.

RIASM طراحی متمرکز پایگاه داده و مبتنی بر پلاگین را اتخاذ می کند که شامل چهار ماژول اصلی برای هر وظیفه فرعی است. در حال حاضر RIASM از توییتر به عنوان منبع داده استفاده می کند. به عنوان یک سیستم متمرکز در پایگاه داده، ماژول های آن فقط با پایگاه داده ارتباط دارند و مستقل از یکدیگر هستند. خرابی یک ماژول مستقیماً بر سایر ماژول ها تأثیر نمی گذارد. به عنوان مثال، زمانی که ماژول دانلود توییت ها کار نمی کند، ماژول دانلود تصویر همچنان می تواند با بازیابی توییت های دانلود شده از پایگاه داده، تصاویر را دریافت کند. اگر ماژول Image Downloading شکست خورد، Image Analyzerهنوز هم تصاویر بدون تجزیه و تحلیل را بازیابی می کند تا زمانی که همه تصاویر دانلود شده آنالیز شوند. جزئیات بیشتر در زیر بخش های زیر ارائه شده است.

3.1.1. ماژول دانلود توییت

به دلیل حجم عظیمی از دادههای در حال پخش، ما توییتها را به عنوان دادههای داغ و دادههای سرد [ 40 ] دستهبندی کردیم تا آنها را بهطور مؤثر بازیابی و بهروزرسانی کنیم. داده های داغ باید فوراً قابل دسترسی باشند، در حالی که داده های سرد کمتر مورد دسترسی قرار می گیرند. توییتهای دانلود شده جدید (یعنی دادههای داغ) به طور موقت در یک پایگاه داده رابطهای (MySQL در این مطالعه) ذخیره میشوند و توسط ماژولهای دیگر بازیابی میشوند. هنگامی که تجزیه و تحلیل تصویر مرتبط به پایان رسید، توییت ها به عنوان داده سرد مشاهده می شوند و به عنوان پردازش برچسب گذاری می شوند و سپس در Impala [ 41 ] بارگذاری می شوند، که یک موتور جستجوی SQL پردازش موازی منبع باز برای داده های ذخیره شده در یک خوشه کامپیوتری است که Apache Hadoop را اجرا می کند. .

RIASM توییتهای دارای برچسب جغرافیایی در زمان واقعی را از Twitter Streaming API دانلود میکند. توییت های ارسال شده در منطقه مورد علاقه بدون توجه به زبان نوشتاری آنها جمع آوری و در پایگاه داده ذخیره می شوند و به دنبال آن کلمات کلیدی و هشتگ ها فیلتر می شوند. Streaming API توییتها را در قالب JSON (JavaScript Object Notation) با دهها فیلد، به عنوان مثال، شناسه توییتها و آدرسهای اینترنتی تصاویر آپلود شده، فشار میدهد. قبل از ذخیره توییت ها در پایگاه داده، توییت دانلود کنیدماژول بدون به تعویق انداختن سرعت ثبت توییتها، مانند محاسبه امتیاز احساسات برای هر توییت، تجزیه و تحلیل متن را در زمان واقعی انجام میدهد. یک افزونه ترجمه در RIASM تعبیه شده است تا توییت های نوشته شده توسط زبان های غیر هدف را بتوان به زبان مقصد مانند انگلیسی ترجمه کرد و در پایگاه داده ذخیره کرد. ایموجیها که بهشدت در رسانههای اجتماعی استفاده میشوند، برای متنکاوی جهانی نیز بافتسازی شدهاند. API استریم حدود 10 تا 20 توییت با برچسب جغرافیایی در هر ثانیه در ایالات متحده ارسال می کند و حدود 10٪ از آنها دارای مختصات طول و عرض جغرافیایی دقیق هستند. این آمار در فوریه 2019 ثبت شده است و ممکن است به دلیل عملیات توییتر یا رفتارهای کاربر تغییر کند. توییت های جمع آوری شده به صورت دوره ای (مثلاً هر دقیقه) ذخیره می شوند.

3.1.2. ماژول دانلود تصویر

در مقایسه با دانلود توییت، دانلود تصویر وقت گیر و منابع فشرده است. حدود 10 درصد از توییت ها دارای تصاویر پیوست شده اند. برای دانلود تصاویر جدید ارسال شده در زمان واقعی، یک رویکرد چند پردازشی برای سرعت بخشیدن به روند دانلود اعمال می شود. در ماژول Images Downloading ، هر فرآیند دانلود به طور مستقل با پایگاه داده ارتباط برقرار می کند، مانند دریافت توییت های پردازش نشده و برچسب گذاری آنها به عنوان پردازش شده پس از دانلود تصاویر. تصاویر دانلود شده به عنوان فایل هایی که با شناسه های توییت نام گذاری شده اند ذخیره می شوند، بنابراین فایل های تصویری را می توان به راحتی به توییت های اصلی متصل کرد.

دانلود تصاویر از توییتهای همزمان نسبتاً ساده است زیرا تصاویر ارسالشده دارای URL متناظر (یاب منبع یکسان) در توییتهای JSON هستند. زیرسیستم می تواند تصویر را مستقیماً از URL دریافت کند.

در برخی از توییت ها، کاربران URL های خارجی را به اشتراک می گذارند. حدود 30 درصد از URL ها به پست های وب سایت های رسانه های اجتماعی (به عنوان مثال، Twitter.com و Instagram.com ) پیوند دارند. این تصاویر خارجی نیز دانلود می شوند. از آنجایی که توییتر URL کامل را به URL کوتاه (کوچک) کوتاه می کند، مانند « https://t.co/Qi8Xs5jopp »، ما از یک درایور مرورگر برای باز کردن URL کوتاه و دریافت URL کامل استفاده کردیم (به عنوان مثال، https:// www.instagram.com/p/8WY30zr7F6GkXdywqP7pJJfuLPrrMncIjG2yc0/ ). اگر URL از یک وب سایت رسانه اجتماعی آمده باشد، برنامه صفحه HTML خود را دریافت کرده و تصاویر تعبیه شده در فایل HTML را دانلود می کند. جدول 1 پنج توییت و آدرس های اینترنتی کوتاه آنها را به عنوان نمونه فهرست می کند. دو صفحه وب از URLهای توییت دوم و چهارم نشان داده شده استشکل 2 .

سرعت دانلود با سرعت دسترسی به اینترنت و عملکرد کامپیوتر (به عنوان مثال، هسته های CPU و پهنای باند) تعیین می شود. در تست ما، RIASM می تواند 4 تا 10 تصویر در ثانیه دانلود کند.

3.1.3. ماژول تحلیل تصویر

این ماژول تصاویر تازه دانلود شده را از پایگاه داده بازیابی می کند و سپس آن تصاویر را به یک مدل آموزش دیده برای تشخیص عکس های سیل زده تغذیه می کند. ردیاب عکس سیل از پردازندههای گرافیکی برای افزایش سرعت استفاده میکند. نتایج در پایگاه داده ذخیره می شود. ما این ماژول را بهعنوان قابلیت پلاگین پیادهسازی کردیم، به این معنی که مدل تشخیص عکس سیل را میتوان با سایر آنالیزورهای تصویر، مانند آشکارساز گردباد یا آشکارساز آتشسوزی جایگزین کرد. چنین تحلیلگرهایی می توانند به صورت موازی اجرا شوند و پایگاه داده و ماژول های دانلود توییت/تصویر یکسانی را به اشتراک می گذارند. به عنوان مثال، ما یک آشکارساز شی YOLO-v3 [ 42 ] و یک مدل تشخیص چهره را با استفاده از استراتژیهای ذکر شده به عنوان ویترین اضافه کردیم. تحلیلگرهای تصویر به طور مستقل تصاویر را بازیابی می کنند و نتایج را با پرس و جوهای SQL در پایگاه داده یکسان ذخیره می کنند.

3.1.4. ماژول تأیید نتایج مبتنی بر WebGIS

عکسهای بدون سیل اکثریت توییتها را حتی در یک رویداد سیل (بیش از ۹۵ درصد) به خود اختصاص میدهند. بنابراین، آشکارساز ممکن است به اشتباه مقدار قابل توجهی از عکسهای بدون سیل را بهعنوان سیل برچسبگذاری کند. علاوه بر این، عکس های سیل از رسانه های اجتماعی بسیار متفاوت است. بنابراین دانش و تجربه انسانی در یک طبقه بندی قابل اعتماد مورد نیاز است. RIASM یک برنامه WebGIS را برای اپراتورهای انسانی متصل می کند تا نتایج طبقه بندی شده خودکار را غربال کند و عکس های برچسب گذاری شده را با موقعیت جغرافیایی مرتبط کند. این رابط بر اساس نقشه گوگل است که هم تصویر و هم توییت را در سیستم نمایش می دهد ( شکل 3 ). حتی کاربرانی که آموزش دیده اند نیز می توانند تعیین کنند که آیا یک عکس سیل است یا خیر. سایر اطلاعات ورودی توسط کاربران مانند ارتفاع آب نیز می تواند در پایگاه داده ثبت شود.

3.2. مجموعه داده و آموزش

یک مجموعه داده آموزشی برای آموزش CNN ها مورد نیاز است. از آنجایی که هیچ مجموعه داده عکس سیل در دسترس عمومی وجود ندارد، ما یک مجموعه داده آموزش عکس های سیل را از تصاویر رسانه های اجتماعی ساختیم. منطق استفاده از تصاویر از رسانه های اجتماعی، نمایش طیف گسترده ای از تصاویر است. دانلود تصاویر سیل از موتورهای جستجو یا سایر مجموعه دادههای موجود روش سادهتری برای ساخت مجموعه داده است، اما واریانس عکسهای سیلآلود و عکس غیرسیلآمیز کمتر نشان داده شده است. ما از تصاویر رسانههای اجتماعی فقط برای حفظ عکسهای گرفته شده توسط شهروندان آماتور استفاده کردیم، نه عکسهای نمادین سیل که توسط روزنامهنگاران یا عکاسان باتجربه تهیه شده بودند. در مجموعه دادههای ما، بسیاری از عکسهای سیل صحنههای سیلزده داخل خانه را ضبط میکنند و با عکسهای سیل که از جستجوی گوگل بازیابی شدهاند، متفاوت هستند.

عکس سیل تنها بخش کوچکی از کل مخزن توییت را اشغال می کند. به عنوان مثال، توییتهای دارای «سیل» شامل 0.034 درصد از مخزن توییت ما با 800 میلیون توییت از سال 2016 تا 2018 در ایالات متحده است. برچسب زدن دستی عکس های سیل در کل مخزن غیرممکن است. این تحقیق از روش تکراری برای جمع آوری عکس های سیل از کل مخزن استفاده می کند. فهرستی از حدود 800 توییت جمعآوری شد و به صورت دستی در یک رویداد سیل در سال 2017 تأیید شد. یک تیم 11000 توییت دارای برچسب جغرافیایی را بررسی کردند و حدود 800 مورد از آنها را مرتبط با سیل برچسبگذاری کردند. در میان این 800 توییت، 430 تصویر سیل وجود دارد. با این حال، مجموعه داده آموزشی از 430 نمونه مثبت به اندازه کافی برای آموزش یک CNN بزرگ نیست. با استفاده از موتورهای جستجوی تصویر Google.com و Bing.com، ما 1500 تصویر سیل اضافی را برای غنی سازی مجموعه داده آموزشی جمع آوری کردیم. در مورد نمونه های منفی، 1500 تصویر بدون سیل به طور تصادفی از ImageNet انتخاب می شوند [ 43 ]. با توجه به اینکه این عکسهای سیلآلود و بدون سیل از منابع مختلفی میآیند، میتوانند یک مجموعه داده آموزشی اولیه را تشکیل دهند.

ساخت مجموعه داده آموزش سیل یک فرآیند تکراری است. مجموعه داده اولیه برای آموزش یک CNN 2 لایه ساده استفاده شد. سیانان آموزشدیده عکسهای سیل را از تصاویر توییتهای حاوی «سیل» در مخزن ما در ایالات متحده آمریکا در سالهای 2016 تا 2017 استخراج میکند (به استثنای توییتهای استفاده شده در بخش 4.1) .مورد 1: سیل هیوستون 2017). در ابتدا، CNN آموزش دیده به دلیل ناقص بودن مجموعه داده های آموزشی اولیه، دقت پایینی دریافت می کند. بسیاری از تصاویر دارای برچسب اشتباه هستند. با این حال، نسبت عکس سیل در نتایج طبقه بندی با برچسب “سیل” بالاتر از توزیع اصلی است. یک حاشیه نویس انسانی می تواند به طور موثر عکس های واقعی سیل را در نتایج “سیل” انتخاب کند. سپس عکس های سیل تایید شده به عنوان مجموعه داده آموزشی برای آموزش مجدد CNN استفاده می شود. در هر تکرار، یک حاشیه نویس انسانی به پاکسازی عکس های طبقه بندی شده سیل به عنوان مجموعه داده آموزشی جدید کمک می کند. پس از تکرارهای سروال، اکثر عکس های سیل به مجموعه داده آموزشی منتقل می شوند. در مرحله آموزش، CNN توسط یک مجموعه داده متعادل آموزش داده شد، به این معنی که تعداد عکسهای غیر سیل و سیل یکسان بود. در مجموعه داده آموزشی نهایی، تمام تصاویر از موتورهای جستجو حذف شدند و 3000 عکس سیل باقی مانده است. در این مرحله هم عکس های سیل و هم عکس های غیر سیل از شبکه های اجتماعی گرفته شده است.

3.2.1. معیارهای شناسایی عکس سیل

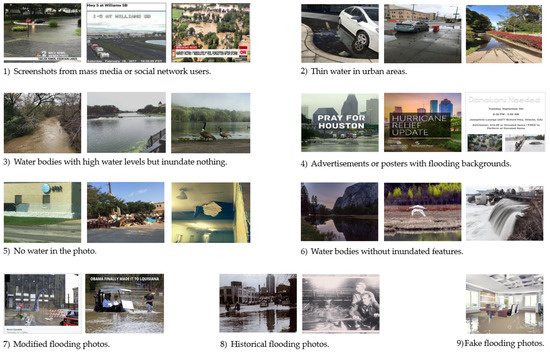

ما هیچ تعریف خاصی برای عکس های سیل در ادبیات پیدا نکردیم، بنابراین معیارهایی را برای شناسایی عکس های سیل ایجاد کردیم. در ابتدا، متوجه شدیم که برخی از عکسهایی که سیل را نشان میدهند، ممکن است لزوماً برای پاسخدهندگان بلایای طبیعی مفید نباشند، بهعنوان مثال، پوسترهای «دعا برای هیوستون» و عکسهای سیل تاریخی. این عکسها «مربوط به سیل» بودند، اما برای توصیف یک رویداد جاری سیل مفید نیستند. ما متوجه هستیم که عکس سیل شناسایی شده باید اطلاعات موجود در محل را در مورد یک رویداد جاری سیل برای آگاهی موقعیتی قابل اعتمادتر منعکس کند. علاوه بر این، ویژگیهایی مانند خانهها، ماشینها یا درختان، اشیایی هستند که معمولاً در آبها ظاهر نمیشوند. بنابراین، وجود این ویژگی ها در بدنه های آبی در شناسایی عکس های سیلاب حیاتی است. عکس سیل باید حاوی ویژگی هایی باشد که توسط آب غرق شده اند. در مقابل، عکسی که ویژگیهای سیلآلود ندارد، نمیتواند اطلاعات بصری قابل تشخیصی درباره سیل جاری ارائه دهد، عکسی بدون سیل است. بنابراین، “عکس سیل” را به عنوان یک عکس در محل حاوی ویژگی های غرقابی تعریف می کنیم که سیل جاری را منعکس می کند و اطلاعات بصری دست اول را ارائه می دهد.

با چندین دور پالایش نتایج طبقهبندی طبقهبندیکننده اولیه، معیارهای تفصیلی به تدریج ایجاد شد. جدول 2 و جدول 3 قوانینی را برای شناسایی عکس های سیل و غیر سیل نشان می دهد. شکل 4 و شکل 5 نمونه هایی از آن قوانین را نشان می دهد. برای اطمینان از ثبات در هنگام توسعه معیارها، فقط یک حاشیه نویس انسانی عکس های سیل را برچسب گذاری کرد. در صورت لزوم، حاشیه نویس با سایر اعضای تیم تحقیقاتی برای رفع ابهامات و تجدید نظر در معیارها بحثی ترتیب داد.

3.2.2. آموزش و انتخاب CNN

پس از نهایی شدن مجموعه داده آموزشی، ما مجموعه داده را با قرار دادن تصادفی 75٪ از عکس های سیل در یک مجموعه آموزشی و 25٪ باقی مانده در یک مجموعه آزمایشی تقسیم کردیم. مجموعه آموزش و مجموعه آزمون توزیع یکسانی دارند که مجموعه داده به طور تصادفی تقسیم شده است. در حال حاضر هیچ قانون طلایی برای اندازه مجموعه آموزشی و ست تست وجود ندارد. نسبت 75:25 مورد استفاده در مطالعه ما مشابه قانون رایج 70:30 است که در [ 44 ] ذکر شده است. تعداد عکس های سیل در مجموعه آموزشی 2250 و در مجموعه تست 750 عکس بوده است.

در هر مجموعه تعداد عکس های سیل و غیر سیلابی برابر بود. پس از آموزش CNN با استفاده از مجموعه آموزشی، دقت با مجموعه آزمون با استفاده از متریک در معادله (1) ارزیابی شد:

این مطالعه چهار معماری محبوب CNN را که از قبل آموزش دیده بودند، از جمله VGG [ 24 ] ResNet [ 25 ]، DenseNet [ 45 ] و Inception V3 [ 36 ] را تنظیم کرد تا مشخص کند کدام یک برای تشخیص عکس سیلابی مناسبتر است. ما مستقیماً از این چهار مدل از پیش آموزش داده شده توسط ImageNet [ 43 ] از مدلهای داخلی PyTorch استفاده کردیم. از آنجایی که مجموعه آموزشی نسبتاً کوچک بود، ما از تمام نمونهها برای آموزش مدلها بدون اعمال اعتبار متقاطع k-fold استفاده کردیم. ما فقط تعداد نورون های خروجی در آخرین لایه خطی را به دو تغییر دادیم که نشان دهنده دو کلاس Flooding و Non_flooding است.و سپس مدل 200 دوره را روی دو پردازنده گرافیکی Nvidia Titan xp با استفاده از نرخ یادگیری 0.001 آموزش داد. روند آموزش حدود 10 ساعت طول کشید. به طور مشابه، VGG16 و DenseNet201 را از ابتدا آموزش دادیم. همانطور که در جدول 4 نشان داده شده است ، VGG 16 که از ابتدا آموزش داده شده است، بالاترین دقت (93%) را به همراه دارد. این مدل های آموزش دیده همچنین به فراخوان های مشابه و دقتی در حدود 0.9 منجر شدند. بنابراین، ما از VGG 16 آموزش دیده از ابتدا در سیستم RIASM خود استفاده می کنیم. علاوه بر این، هوانگ و همکاران. [ 25 ] از داده های آموزشی ما به عنوان بزرگترین زیرمجموعه استفاده کرد و با استفاده از اعتبارسنجی متقاطع پنج برابری و روش یادگیری انتقال پیچیده تر، دقت یکسانی (94/92%) را یافت. این بیشتر اعتبار مجموعه داده آموزشی ما را تأیید می کند.

شاید به دلیل تفاوت محتویات بین عکس های سیل و تصاویر ImageNet، یادگیری انتقال نتیجه رقابتی به دست نمی آورد. عکس های سیل تصاویر صحنه هستند و حاوی اشیاء زیادی هستند، در حالی که تصاویر ImageNet دارای اشیاء غالب هستند.

4. مطالعات موردی RIASM

4.1. مورد 1: سیل هیوستون در سال 2017

VGG16 آموزش دیده در سال 2017 در مجموعه داده های توییت سیل هیوستون اعمال شد. این مجموعه داده شامل حدود 140000 توییت با برچسب جغرافیایی در کلانشهر هیوستون است که سیل بی سابقه ناشی از طوفان هاروی 2017 را متحمل شد. زمان ارسال توییت ها از 115 تا 2 اوت از 1 اکتبر متغیر بود. 2017. از بین 39000 عکس دانلود شده، 2237 عکس توسط VGG16 آموزش دیده برچسب سیل زده شده است.

دقت این مجموعه داده بسیار نامتعادل توسط تصاویر غالب بدون سیل تحریف می شود، بنابراین ما از دقت و یادآوری در این مورد مطالعه استفاده کردیم، به معادلات (2) و (3) مراجعه کنید. شکل 6 و شکل 7 نمونه هایی از نتایج تشخیص را نشان می دهد. در این مجموعه داده 1400 مورد از 2237 مورد به عنوان سیل واقعی پس از بررسی دستی بر اساس قانون جدول 2 و جدول 3 تأیید شد.. بنابراین دقت عکس سیل 63 درصد (1400/2237) بود. به دلیل شدت کار، 20 درصد از نتایج غیرسیل را به صورت دستی بررسی کردیم و 15 عکس سیل پیدا کردیم، که به این معنی بود که حدود 75 عکس غیر سیل توسط CNN آموزش دیده از دست رفته است. یادآوری عکس های سیل 95٪ (100٪—75/1475) بود. این نشان می دهد که طبقه بندی کننده هنگام اعمال آن بر روی داده های واقعی با توزیع بسیار نامتعادل عملکرد قابل قبولی دارد.

4.2. مورد 2: طوفان فلورانس سیل در سال 2018

در 14 تا 17 سپتامبر 2018، طوفان فلورانس خسارات گسترده ای را در منطقه ساحلی کارولینای شمالی و کارولینای جنوبی ایجاد کرد [ 46 ]. باعث بارندگی شدید شد که منجر به ثبت سیل در کارولینا شد [ 47 ]. بیش از 1.2 میلیون نفر در منطقه آسیب دیده تحت دستور تخلیه اجباری بودند [ 48 ]. ما از 14 تا 30 سپتامبر 6975 تصویر از 136000 توییت با برچسب جغرافیایی پست شده در کارولیناس را دانلود کردیم و VGG16 آموزش دیده 818 عکس سیل را برگرداند. از عکسهای سیل شناساییشده، 372 عکس از 818 عکس مثبت واقعی پس از تأیید دستی بودند ( شکل 8). دقت 45.5٪ (373/818)، کمتر از نتایج در هیوستون سیل 2017 بود. به دلیل حجم کاری سنگین، ما نتیجه عکس بدون سیل را بررسی نکردیم، بنابراین فراخوان محاسبه نشد.

5. بحث و گفتگو

رویکردهای به موقع برای آگاهی از وضعیت سیل و نقشه برداری سریع مورد نیاز است. در همین حال، استفاده از این رویکردها باید مقرون به صرفه باشد. به دست آوردن تصاویر سنجش از دور یک راه موثر برای جمع آوری وضعیت پیوسته یک منطقه بزرگ سیل زده است [ 49 ، 50 ]]. با این حال، شرایط آب و هوایی شدید مانند ابرها همراه با بارندگی شدید، سنسور هوابرد یا ماهواره را از به دست آوردن تصاویر نوری باز می دارد. در بهترین سناریوها، ماهوارههای نوری تجاری میتوانند چندین روز پس از یک رویداد تصاویری با وضوح بالا به دست آورند. این به شدت استفاده قابل اعتماد از سنجش از راه دور ماهواره ای را برای مرحله واکنش اضطراری (یعنی 3 روز اول یک فاجعه) محدود می کند. سایر محدودیتهای تکنیکهای سنجش از دور شامل زمان پیش پردازش طولانی برای تصحیح هندسی و جوی تصویر، راندمان پایین و خطر بالای استقرار سیستمهای هوایی بدون سرنشین (UAS) و دشواری تخمین ارتفاع آب از تصاویر دو بعدی است. ما معتقدیم که منابع سنجش از دور هوایی یا ماهواره ای نقش مهمی دارند. با این حال،

عکس های سیل استخراج شده توسط RIASM برای چندین هدف مفید است. عکس های سیل را می توان به عنوان مشاهدات مستقل از رویدادهای سیل استفاده کرد. ارتفاع آب تخمین زده شده از عکس های سیل را می توان برای به دست آوردن یک نقشه به موقع طغیان بدون بازدید میدانی استفاده کرد، که در یک رویداد سیل در حال انجام چالش برانگیز بوده است [ 6 ]]. همچنین، زمان وقوع سیل را می توان از ابرداده ها (زمان ارسال شده یا متن) استخراج کرد، از این رو یک نقشه سیلابی پویا ایجاد کرد. بررسی میدانی سنتی واترمارک های بالا فاقد بعد زمانی است زیرا بررسی پس از رویداد سیل از اطلاعات حکایتی (مثلاً خطوط زباله یا خطوط آب) انجام می شود، در حالی که عکس های سیل استخراج شده از رسانه های اجتماعی ارتباط زمانی بالایی را ارائه می دهند. عکسهای سیل همچنین میتوانند بهعنوان منبع داده تکمیلی برای اصلاح ارزیابیها بر اساس تصاویر سنجش از دور استفاده شوند. به عنوان مثال، Schnebele و Cervone [ 10 ] و Huang [ 12 ، 13 ، 14] از VGI ادغام کننده پهپاد، EO-1 و تصاویر Landsat 8 برای بهبود واکنش سیل استفاده کرد. این محققان VGI مربوط به سیل (عمدتاً عکسها) را بهعنوان نقاط مشاهده قابل اعتماد در نظر گرفتند و از این نکات برای اصلاح احتمال سیل در مناطق مجاور استفاده کردند. از این نظر، RIASM این پتانسیل را دارد که در سیستمهای سنتی نقشهبرداری سیل گنجانده شود تا شکافهای دانش را پر کند و تأیید بیشتری از وسعت یا بزرگی یک فاجعه ارائه دهد.

RIASM را می توان به عنوان یک پلت فرم تجزیه و تحلیل تصویر رسانه های اجتماعی در زمینه های مختلف مشاهده کرد. مکانیزم پلاگین RIASM را قادر میسازد تا با اتصال الگوریتمها و مدلهای دستهبندی تصویر جدید، مانند گردباد، آتشسوزی، زلزله، و آشکارسازهای عمومی اشیا، سایر وظایف آنالیز تصاویر را به راحتی انجام دهد. یک مدل YOLO-v3 برای تشخیص اشیاء معمولی (به عنوان مثال، شخص، ماشین و گربه) اضافه شد و نتایج برخی از پدیده های جالب را نشان می دهد. به عنوان مثال، در ایالات متحده، سگ ها بیشتر از سایر کشورها در عکس های رسانه های اجتماعی ظاهر می شوند. سایر مدلهای مبتنی بر دیداری نیز میتوانند مورد استفاده قرار گیرند، مانند تشخیص خشونت [ 51 ، 52 ]، تشخیص چهره [ 53 ]، استخراج جنسیت و سن [ 54 ]، یا تجزیه و تحلیل رنگ پوست [ 55 ]].

از نظر مقیاسپذیری، RIASM میتواند تمام توییتهای بلادرنگ را از API رایگان توییتر استریمینگ (حدود ۵۰ توییت در ثانیه) پردازش کند و میتواند در هنگام پردازش توییتهای از پیشدانلود شده در ایستگاه کاری ۸ هستهای CPU ما، ۲۰۰ توییت در ثانیه را مدیریت کند. طبقه بندی تصویر یا سایر تحلیل های تصویر مانند تقسیم بندی معنایی [ 56] به چنین محاسبات GPU قابل توجهی نیاز ندارد. از آنجایی که هر ماژول RIASM به عنوان یک فرآیند مستقل طراحی شده است، قابلیت دانلود و تجزیه و تحلیل داده ها را می توان با شروع فرآیندهای بیشتر به دست آورد. در نتیجه، RIASM میتواند با سختافزارهای قدرتمندتر مانند هستههای بیشتر CPU و کارتهای GPU افزایش یابد. در رابطه با راستیآزمایی انسانی، دو مطالعه موردی نشان دادند که عکسهای سیل استخراجشده تنها حدود 1 درصد از توییتهای دارای برچسب جغرافیایی در طول رویدادهای سیل را تشکیل میدهند. با در نظر گرفتن حداکثر سرعت دانلود 50 توییت در ثانیه، حدود 30 عکس سیل در هر دقیقه استخراج میشود که میتواند توسط یک نفر در طول فرآیند تأیید انسانی مدیریت شود.

RIASM به خوبی طراحی شده است تا توییت ها را به چندین زبان از جمله ایموجی ها ذخیره کند. تحقیقات دیگر در مورد تجزیه و تحلیل متن توییت می تواند در سیستم تعبیه شود، برای مثال، استفاده از متن و تصاویر با هم برای طبقه بندی توییت های مرتبط با سیل [ 20 ]. معماری RIASM همچنین این پتانسیل را دارد که با استخراج خودکار اطلاعات جمعیت شناختی (به عنوان مثال، جنسیت، سن و نژاد) از عکسهای توییت، با مسائل معرف دادههای توییتر [ 57 ] مقابله کند، که ممکن است برای مطالعات تحرک انسان بر اساس رسانههای اجتماعی مفید باشد. 58 ، 59 ].

مطالعات بین فرهنگی مبتنی بر RIASM امیدوارکننده است، اگرچه ما فقط تحقیقات اولیه را آغاز کرده ایم. تصاویر بصری و بدون زبان هستند. با توجه به توییتهای دارای برچسب جغرافیایی دانلود شده، حدود 40 درصد از توییتها به بیش از 30 زبان غیر از انگلیسی مانند پرتغالی (13٪)، اسپانیایی (9٪) و ژاپنی (6٪) نوشته شدهاند. بدیهی است که نسبت توییت هایی که از یک زبان خاص استفاده می کنند بسته به منطقه جغرافیایی در جهان متفاوت است. قابل ذکر است، تحقیق بر اساس محتوای تصویر محدود به زبان نیست. تصویر “بدون زبان” است. برای متن کاوی، RIASM به API ترجمه Google متصل شده است تا توییتها را به انگلیسی یا زبانهای دیگر ترجمه کند. سایر کتابخانه های ترجمه منبع باز (به عنوان مثال، Open NMT [ 60]) را می توان در یک رویکرد مشابه تعبیه کرد. تحقیقات قابل توجهی برای کشف اهمیت و تفاوت به دلیل زبان در توییت های جغرافیایی باقی مانده است.

6. محدودیت ها و تحقیقات آینده

حدود 4800 عکس سیل جمعآوریشده در این تحقیق از تصاویر رسانههای اجتماعی منتشر شده در ایالات متحده طی سالهای 2016 تا 2017 با اضافه شدن دو رویداد سیل گرفته شده است. این عکسها برای آموزش مجدد CNN برای شناسایی عکسهای جدید سیل که در رویدادهای سیل آینده ارسال میشوند، مفید هستند. با این حال، این 4800 عکس سیل و عکسهای غیرسیلآمیز بهطور تصادفی انتخابشده در این مطالعه هنوز هم نشاندهنده تصاویر رسانههای اجتماعی هستند که دارای تنوع زیاد و توزیع طبقاتی بسیار نامتعادل هستند. این عدم بازنمایی منجر به دقت پایین هنگام استفاده از CNN آموزش دیده در تصاویر رسانه های اجتماعی بلادرنگ می شود. افزایش داده ها، مانند چرخش و چرخش در تمرینات آزمایش شده است، اما نتایج بهبود قابل توجهی را ارائه نمی دهد. روشهای تقویت دادهها و استراتژیهای آموزشی بیشتری باید آزمایش شوند. بودا و همکاران56 ] نمونه برداری بیش از حد را به عنوان اولین انتخاب برای مجموعه داده آموزشی نامتعادل توصیه می کند، به این معنی که از ماکت عکس های سیل برای تشکیل نمونه های مثبت بیشتر برای مطابقت با نمونه های منفی استفاده کنید. با این حال، شناسایی تعداد معقولی از عکسهای بدون سیل برای آموزش مجدد انواع تصاویر رسانههای اجتماعی نیاز به تحقیقات بیشتری دارد.

هنگام استفاده از CNN آموزش دیده در مجموعه داده های هیوستون سیل در سال 2017، یادآوری عکس های سیل 95٪ و دقت 63٪ بود. در سیل طوفان فلورانس در سال 2018، دقت 46٪ بود. در مقایسه با مجموعه تست متعادل در فرآیند آموزش ( بخش 3.2این نتایج دو محدودیت CNN آموزش دیده را نشان می دهد. اولین محدودیت، دقت کمتر در تصاویر شبکه های اجتماعی بسیار نامتعادل است. در دو مورد مطالعه، عکسهای سیل شامل کمتر از 5٪ از کل مجموعه تصویر بود که بسیار کمتر از مجموعه آزمایشی (50٪) مجموعه داده آموزشی بود. دقت سیانان از بیش از 90 درصد به حدود 50 درصد کاهش یافت و بسیاری از عکسهای غیرسیلآمیز را به اشتباه بهعنوان سیل نامگذاری کرد. با این حال، فراخوان 95 درصد در سیل هیوستون در سال 2017 قابل قبول بود. محدودیت دیگر این بود که در حوادث سیل شدید، ساکنان در معرض خطر احتمالاً قبل از سیل تخلیه میشوند که منجر به تعداد کم پستهای رسانههای اجتماعی میشود. بنابراین، تعداد عکسهای کشفشده سیل ممکن است کاهش یابد، زیرا پستهای رسانههای اجتماعی کمتر با برچسبهای جغرافیایی در محل سیل یا ساکنان اصلاً پست نکردهاند. از این رو، ممکن است تعداد عکسهای سیل شناسایی شده به دلیل پستهای کمتر در رسانههای اجتماعی کاهش یابد. مورد مطالعه طوفان فلورانس در سال 2018 به وضوح این کاهش را نشان داد.

این مطالعه بر روی نمونهسازی سیستمی برای تشخیص عکس سیل در زمان واقعی از رسانههای اجتماعی، به جای بررسی یک آشکارساز عکس سیلابی پیشرفته تمرکز داشت. تحقیقات بیشتری برای بهبود دقت و یادآوری در محیط تولید مورد نیاز است. برای آموزش یک مدل با کارایی بالا باید فاکتورهای زیادی در نظر گرفته شود. معماری های محبوب آزمایش شده در این مطالعه نتایج مشابهی در این مجموعه آزمایشی به دست آوردند، معماری های جدید توسعه یافته ممکن است عملکرد بهتری داشته باشند. متخصصانی که میخواهند از CNN برای طبقهبندی تصاویر در حوزههای خود استفاده کنند، باید مجموعه دادههای آموزشی را با دقت با توجه به سؤالات تحقیقاتی خود بسازند. به عنوان مثال، عکس سیل در تحقیق ما به عنوان عکسی در محل تعریف شد که اطلاعات بصری دست اول در مورد سیل در حال انجام را ارائه می دهد و باید ویژگی های غرقابی داشته باشد.

7. نتیجه گیری

این تحقیق سیستمی به نام RIASM را برای جمع آوری، ذخیره و تجزیه و تحلیل تصاویر ارسال شده در توییتر در زمان واقعی طراحی و نمونه سازی کرد. ما با رویکردی عملی برای به دست آوردن بینش های سیل آسا از داده های رسانه های اجتماعی عظیم بر اساس یادگیری عمیق، به ادبیات و جامعه کمک می کنیم. این سیستم به مدل CNN اجازه می دهد تا زمانی که عکس های سیل تایید شده توسط تحلیلگر بیشتری به مجموعه آموزشی به شیوه ای تکراری اضافه می شود، توسط مجموعه داده های آموزشی بزرگتر دوباره آموزش داده شود. دقت کلی تشخیص عکس سیل 93٪ در یک مجموعه تست متعادل بود، و دقت بین 46 تا 63٪ در توییت های بسیار نامتعادل در دنیای واقعی در طول دو رویداد سیل متغیر است. عکسهای سیل استخراجشده از رسانههای اجتماعی با RIASM با ارائه مشاهدات مستقل از رویدادهای سیل روی زمین، آگاهی موقعیتی را برای امدادگران اضطراری افزایش میدهد.

بدون دیدگاه